У вас падает трафик на сайте, вы не знаете, почему это происходит, и что делать? Причин снижения может быть много, в этой статье я расскажу основные, и покажу, как вернуть посетителей на ваш сайт.

Но сразу хочу оговорить, что если у вас резко упала посещаемость сайта в одной из поисковых систем, например, в яндексе, то скорее всего вы попали под какой-то фильтр, например, вот так:

Санкции ПС — это совсем отдельная большая тема, и в рамках этой статьи я ее рассматривать не буду. Разговор идет только про постепенное снижение посещаемости в обоих поисковых системах или в одной.

Также я не беру в расчет сезонность (в этом случае все в порядке).

Почему падает трафик на сайте

Вот основные причины (но не все, так как каждый проект индивидуален, а дьявол кроется в мелочах):

- Большое количество дублей страниц

- Каннибализация запросов

- Часть страниц отдают неправильный код ответа сервера

- Слетели мета теги

- Закрытие части страниц или раздела в robots.txt

- Часть страниц, приносящих ранее трафик, выпала из индекса (ноиндекс, 404 или каноникал)

- На части страниц был переписан текст или удалены ключи

- Появились более сильные конкуренты с лучшими ответами на запросы (ключи потеряли трафик)

- Вы забросили ваш сайт и перестали его развивать

Хорошая новость, что все эти причины можно устранить, и посещаемость вернется или даже станет еще больше.

Плохой новости нет.

Как вернуть трафик на сайт

Рассмотрим подробно каждый из вышеприведенных пунктов и найдем решение проблемы.

- Дубли страниц

Движок может генерировать дубли страниц вида:

site.ru/stranica/

site.ru/stranica/?p=abrakadabra

Найти их можно в выдаче яндекса или google (посмотреть обе поисковые системы).

В яндексе я использую оператор host:

В google оператор site:

Устраняется эта проблема программно путем настройки 301 редиректа на основную страницу.

- Каннибализация запросов

Каннибализацию можно найти только, если вы снимаете позиции вашего сайта

Здесь по одному запросу могут вылазить сразу несколько страниц вашего сайта, получается, они конкурируют друг с другом за место в выдаче, со временем поисковик выбрасывает вообще такие страницы далеко за ТОП10.

Это происходит, когда две или более страниц содержат ключевой запрос, релевантный ему контент, и поисковик не может определиться, какая из страниц лучше подходит для ответа.

Решается такая проблема просто — под каждый запрос должна быть только 1 посадочная страница. Если на запрос отвечает 2 или более страниц, то нужно пересмотреть их, убрать вхождения из текста, мета тегов, карточек товаров и так далее.

Через 2-3 апдейта снова снять позиции и посмотреть, встало ли все на свои места. Если проблема не решилась, то повторить процедуру заново до тех пор, пока в выдаче останется только 1 самая релевантная страница.

Поиск проблемных страниц

Следующие проблемы нужно смотреть через сравнение страниц в метрике. Проводим вот такие манипуляции.

Заходим в яндекс метрику. Отчеты — стандартные отчеты — содержание — страницы входа.

Выбираем линейный список.

Выбираем переходы из поисковых систем.

Для того чтобы узнать, почему упал трафик именно с гугла или именно с яндекса, нужно рассматривать только одну поисковую систему.

Выбираем период последний месяц.

Делаем экспорт.

Затем выбираем дату за весь период существования сайта.

Нам не нужны страницы, например, новые или приносящие мало трафика, поэтому ставим фильтр, например, статьи с посещаемостью минимум 300 в месяц (за 2-3 года жизни сайта такая посещаемость 1 статьи вполне нормальная) — 24 мес x 300 = 7200.

Но это я рассматриваю случай с информационными сайтами. Для коммерческих нужно другую посещаемость брать, зависит от ниши, объема рынка, региона продвижения.

При этом я использую правило 80/20 — беру сначала для работы самые трафиковые страницы, чтобы получить сразу максимальный результат. Потом можно установить фильтр намного ниже и поработать уже со всеми остальными страницами.

Аналогично делаем выгрузку в excel.

И вот у нас есть 2 списка страниц за разные периоды. Теперь нужно эти списки сравнить, я делаю это в excel. В итоге нам нужен список страниц, которые есть во втором большом списке, но их нет в первом. Это наши проблемные страницы, у которых просел или совсем исчез трафик.

Что нужно проверить на этих страницах

- Коды ответа сервера

Это можно сделать, например, с помощью программы Neatpeak Spider — пропарсить весь сайт и посмотреть, есть ли важные страницы с кодами ответа, отличными от 200.

- Canonical

Еще смотрим на canonical — правильно ли он настроен, ведет ли на нужные адреса.

Про каноникал я уже писал , почитайте подробнее, что это такое, для чего нужен и как настраивается.

- Noindex

Еще смотрим на закрытие страниц в noindex или disallow в роботсе. Вот такого на важных страницах не должно быть.

Про файл robots.txt я уже писал , почитайте. Если нашлись закрытые страницы, то нужно их просто открыть для индексации.

- Мета теги

Бывает также, что слетают тайтлы или дескрипшены вследствие какой-то технической ошибки или программных работ на сайте. Нужно просмотреть все важные страницы, есть ли на них ли они, как нужно.

- Переписан текст

Еще одной причиной того, что снизился трафик, может быть переписывание текста или удаление ключей ранее приносивших посетителей. Вы как владелец сайта должны знать, переписывался текст на важных страницах или нет.

Очень часто бывает, что при написании нового текста не учитываются ключевые фразы, по которым страница получала трафик. Я имею в виду не ключи, под которые оптимизировался текст, а ключи, по которым приходят посетители.

Их нужно смотреть в яндекс метрике и обязательно учитывать при написании нового текста.

- Конкуренция

Да, сайтов с каждым годом становится все больше, общее качество их улучшается, полнее прорабатывается семантика. И неудивительно, что старые статьи на сайте начинают падать, потому что появляются более лучшие и полные ответы на запросы пользователей.

Я считаю, что через 2-3 года после активного развития проекта нужно заново проводить анализ ниши, конкурентов, заново , и более лучше под новые реалии рынка.

Общие выводы

Это далеко не все причины, по которым может падать трафик. Каждый проект индивидуален, нужно копаться, анализировать более детально. Но в целом, я дал вам направления, куда можно двигаться.

Также обязательно сделайте вашего сайта и проверьте его на . Возможно, найдете что-то интересное.

Если вам понравилась эта статья или была полезной для вас, то поделитесь ею с друзьями в социальных сетях. Если у вас есть вопросы или дополнения — пишите в комментариях, я постараюсь ответить.

За последний год стал отмечать все больше жалоб на то, что падает трафик с Google при практически неизменных позициях основных ключевых слов. Падение трафика за год около 50% – это очень серьезно для коммерческих или информационных сайтов. А такая ситуация отмечается на целом ряде мощных проектов. Народ недоумевает, хотя все довольно просто.

Исследование CTR

Если вы уверены в своих позициях, которые остаются неизменными или даже растут, при этом замечается падение трафика, тогда вам необходимо провести исследование вашего CTR.

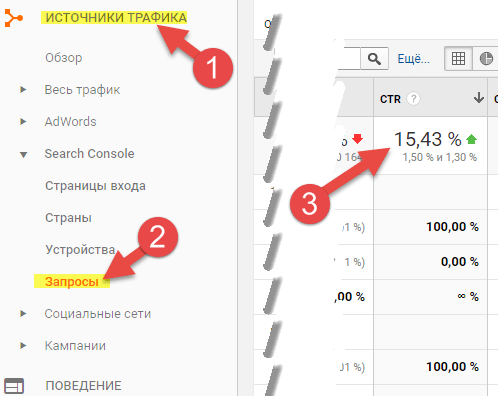

Откройте Google Analytics , перейдите в “Источники трафика” – “Запросы” и сделайте отчет за последнюю неделю (чтобы немного сгладить и усреднить данные).

Теперь в правом верхнем углу идите в диапазон дат и выбирайте сравнение для начала с прошлым годом, а затем и с более отдаленными периодами.

Как правило, наблюдается падение CTR из года в год. При этом, даже рост отдельных позиций не приводит к пропорциональному росту трафика.

Давайте посмотрим в чем тут дело.

Неконкурентоспособный сниппет

Падение CTR возможно связано с падением конкурентоспособности сниппета в органической выдаче. Это связано с тем, что ваши конкуренты ведут работу по оптимизации сниппетов, а вы единожды прописав Title и Description более не заглядывали в них.

Бывает ситуация еще хуже, когда Title или Description не соответствует контенту или устарел. Например, вы год назад проводили какую то акцию по продаже какого то товара и забыли поменять данные на актуальные. И вот вы сидите с распродажами 2017 года в сниппете, хотя на дворе уже 2018 год. Все это вызывает подозрение пользователя и явно снижает CTR.

Проверку ваших сниппетов необходимо проводить с достаточной периодичностью. Равно как и анализ сниппетов конкурентов в органической выдаче.

Общее падение CTR в Google для всей выдачи

Этот виджет позволяет видеть, отображаются ли какие-либо специальные результаты в выдаче поисковой системы Google, по вашим ключевым словам.

Как мы видим, на сегодняшний день в выдаче по всем анализируемым запросам 20,21% из них сопровождается панелью знаний (Knowledge panel), 22,54% – результатами локальной выдачи (Local Pack), на 1,05% запросов выводится карусель и 64% запросов сопровождается изображениями (они в принципе не важны).

В целом, 43% запросов, по которым доминирует исследуемый сайт сопровождается не просто органической выдачей, а выдачей с разнообразными “улучшениями” от Google, которые оттягивают на себя практически весь трафик по этим запросам, так как занимают большую и лучшую часть экрана в органической выдаче.

При этом, анализируемый сайт практически не участвует ни в каких SERP Features (0.11% + 0.35%). Это говорит о том, что сайт не оптимизирован под выдачу в SERP Features и никакая работа по этой оптимизации не проводилась.

Теперь делаем следующее.

На графике (синей линии), нажимаем одну из дат, желательно ровно год назад, чтобы сгладить “сезонность”.

Далее, проверяем объем SERP Features в органической выдаче по вашим запросам. Как мы видим этот объем составляет примерно 38%. То есть за год, “замусоренность” разнообразными хитрыми выдачами в органике выросла на 5%. Причем, наверняка, по наиболее трафиковым ключам (смотрите и анализируйте ключи, расположенные ниже графика, при выборе одного из вида SERP Features).

Учитывая, что сайт никак не представлен в этих SERP Features, вот вам и закономерное падение трафика из за разительного снижения CTR по этим запросам.

Что тут можно сделать.

1. Упереться и продвигать “простые” ключи, где пока отсутствуют SERP Features.

Нужно признать, что мы все через это проходили - в одно ничем неприметное утро трафик сайта резко проседает.

Ситуация сложная, требует взвешенного подхода и хорошей аналитической работы. Многие веб-мастера делают поспешные выводы и без тщательного анализа начинают подозревать «зверинец» Google Panda и Penguin, переходя к активным действиям, которые часто являются ошибочными. Образно говоря, лечение пациента без правильно поставленного диагноза - идея авантюрная, которая может привести к трагическим последствиям.

В этой статье я расскажу вам о том, как установить причины проседания трафика из поисковой системы Google (многие этапы анализа аналогичны и для других поисковых систем, но рассказать о специфике каждой из них в одной статье невозможно).

Предисловие

Нужно верить в лучшее! Иногда причина «страшных» показателей падения трафика кроется не в коварном Google, а в некорректном коде Google Analytics (или же любой другой метрики). Не стоит недооценивать такую вероятность - это случалось и на моей практике, и на практике большинства моих коллег. В первую очередь, проверьте наличие кода аналитики на всех страницах сайта, убедитесь в отсутствии ошибок. Это можно сделать с помощью GA Checker или плагина для Chrome Google Analytics Debugger .

Откуда и какой именно трафик просел?

Первой стадией любого ремонта является определение самой поломки и ее масштаба. В нашем случае необходимо проанализировать трафик - с какой именно поисковой системы он просел, на какие страницы и не является ли такая динамика закономерной для сезона? Приступим.

Заходим в Google Analytics на вкладку «Источники трафика → Каналы» и выбираем область «Organic Search». Указываем период для сравнения и анализируем данные. Нужно обратить внимание на то, с какой именно поисковой системы трафик просел - это важно, поскольку определяет, где именно проблема. Если трафик уменьшился с Google и Yandex, то можно сделать вывод о возможных технических проблемах на сайте либо сезонном спаде посещаемости.

При анализе должное внимание нужно уделить «Страницам входа» (на которые переходят пользователи с ПС). В Google Analytics выберите вкладку «Поведение → Контент сайта → Страницы входа». В сравнении с предыдущим периодом, можно определить, какие именно страницы потеряли трафик, и есть ли такие, где посещаемость осталась без изменений. Данные будут полезны при определении возможного фильтра за неестественные ссылки или же технических проблем на конкретных страницах - все это мы будем разбирать дальше в статье.

Трафик во многих видах деятельности и заметно колеблется. И я говорю не только о таких видах бизнеса, как продажа мотоциклов или лыжного снаряжения, где это очевидно, но и о других, менее явных направлениях. Проверить «сезонность трафика» можно, проанализировав динамику за аналогичный период прошлого года.

Или воспользоваться такими инструментами, как Google Trends или Планировщик ключевых слов (Google AdWords).

Итого: на первом этапе важно локализовать проблему, разобраться, когда и где именно просел трафик, и лишь после этого, имея четкую картину, приступать к анализу возможных причин падения трафика.

Давайте разберем подробно основные возможные причины падения трафика.

2. Проседание трафика, связанное с техническими проблемами сайта

Запрет от индексации, проблемы с внутренней оптимизацией, DownTime сервера могут служить причиной потери трафика. Давайте рассмотрим основные технические моменты, которые непосредственно влияют на ранжирование.

Страницы сайта закрыты от индексации (noindex)

Популярная проблема: при выполнении тех. правок для трафиковых страниц ошибочно прописали сток

"] |

Это приведет к тому, что страницы выпадут из индекса поисковых систем и, соответственно, перестанут получать трафик. Для обнаружения таких проблем можно воспользоваться Screaming Frog Seo Spider или любым другим «пауком».

Страницы сайта закрыты в robots.txt

Да, друзья, и такое случается. Я даже не говорю об экстремальном случае закрытия всего сайта, а, скорее, об , которые происходят из-за невнимательности и, в основном, из благих помыслов. Например, хотели закрыть дубли и прописали

Одна строчка этого кода, прописанная на неканонической странице, может иметь серьёзные последствия - произойдет «слейка» и страница выпадет из индекса. Коварство такой ошибки в том, что можно потерять время, в пустую анализируя ссылочную массу и другие возможные проблемы (а иногда можно и «найти» проблему там, где ее нет). В таком случае, на этапе аудита нужно воспользоваться инструментом типа Screaming Frog Seo Spider для обнаружение проблем с ошибочной каноникализацией страниц.

Сменили ряд URL

Возможен вариант, когда в процессе работы над сайтом изменили структуру URL или внедряли ЧПУ, но 301 редирект настроен не был (ошибочно настроили 302 или вообще не сделали). В результате, вес на новые URL не передастся, появятся дубли, что очень негативно может сказаться на ранжировании и трафике. Либо «старые» страницы заглушили через 404 Not Found, что фактически лишает сайт авторитета и ссылочной массы, которые накопили эти страницы. При миграции страниц обязательной является настройка 301 редиректа.

Слетел 301 редирект с предыдущего домена

С целью выхода из-под санкций или же брендинга, смена домена сегодня не редкость. И если даже на момент «переезда» все было сделано правильно, то это не гарантирует, что в дальнейшем редирект не слетит. Результатом в таком случае может быть проседание позиций вследствие потери статического веса, который передавали страницы предыдущего домена. В процессе аудита можно проверить корректность 301 редиректов через Вertal или же вот такой плагин для Chrome (вы же понимаете, что способов очень много, а приведенные в примере - то, чем, в основном, пользуюсь я).

Не оптимизированные или дублирующиеся мета-теги

Проверьте, не слетели ли оптимизированные мета-теги на ключевых страницах сайта. Последствиям таких действий могут быть существенные проседания трафика с поисковых систем на конкретных страницах (вот тут вам пригодится анализ, описанный ).

Также не стоит забывать и о негативном влиянии на продвижение и трафик такого явления, как дублирование мета-тегов. Быстрый способ проверить наличие таких дублей - в Google Webmaster Tools на вкладке «Оптимизация HTML».

Как вы видите на скриншоте, на сайте есть ряд страниц с дублирующимися Title и Description.

Дублирование страниц

Устранение дублирования страниц является одной из основных целей внутренней оптимизации. Если же к этой задаче не отнестись серьезно, то со временем в индекс могут попадать множество страниц с таким же содержимым, но доступные под другими URL - страницы фильтрации, пагинации, сортировок, пользовательских сессий, страниц корзины и т.д. Чтобы обнаружить проблему, можно воспользоваться тем же Screaming Frog Seo Spider и проанализировать все возможные страницы с get параметрами. Полезно будет заглянуть в Google Webmaster Tools на вкладку «Статус индексирования» и посмотреть количество страниц в индексе и динамику по ним (если вы видите, что за последний месяц Google увидел +10 000 страниц, а новый контент не добавлялся, то это причина задумаются над тем, что происходит). Что касается того, чтобы посмотреть какие страницы находятся в индексе Google через оператор site:mysite.com, то, конечно, это будет не лишним, но многие страницы поисковик все равно не показывает, поэтому особо надеяться на данный способ я бы не советовал.

Проблема с дублирование часто возникает также из-за некорректной настройки ответа сервера на запрос несуществующей страницы (возвращает, для примера, HTTP/1.1 200 OK, а не HTTP/1.1 404 Not Found) - 404 ошибка не возвращается и всевозможные варианты УРЛов попадают в индекс. Проверять ответ сервера удобно через Вertal или же удобный плагин для Chrome Redirect Path .

Проблема с хостингом

Частый DownTime хостинга, медленная скорость отдачи страницы, безусловно, может негативно повлиять на позиции и трафик сайта. Учитывается то, что «медленные» сайты несут негативный пользовательский опыт и часто посетители не дожидаются загрузки страницы, возвращаясь на страницу поиска. Также из-за DownTime сервера поисковые боты не могут нормально индексировать сайт. Обратите внимание, если GoogleBot не может получить доступ к сайту, то вам, скорее всего, будет отправлено сообщение в Google Webmaster Tools с темой «Робот Googlebot не может получить доступ к вашему сайту» - на эту проблему стоит обратить внимание и рассмотреть вариант смены хостинга или перехода на другой тариф.

Сайт «хакнули»

Иногда обнаружить, что сайт был хакнут, не так просто, как кажется многим. Популярной моделью взлома является, например, не размещение ссылок на активных страницах сайта, а создание целых новых категорий спамерского контента, что намного сложнее заметить. Когда поисковая система обнаруживает такие страницы, она пессимизирует сайт целиком, что приводит к проседанию позиций и трафика. К счастью, в своем Google Webmaster Tools поисковая система вас уведомит о проблеме и вы сможете принять правильное меры. Там же (в GWT), на вкладке «Проблемы с безопасностью », можно самостоятельно проверить не обнаружено ли на сайте вредоносное ПО.

Наполнение сайта качественным, полезным и уникальным контентом является основой успешного продвижения. Поэтому, при падении трафика, нужно особенно тщательно проанализировать контентную составляющую - актуальность и уникальность материалов.

Даже если сайт изначально наполнен авторским контентом и вы ни у кого ничего «не заимствовали», это не гарантирует отсутствие проблем - возможно, украли у вас. Как не абсурдно это звучит, но довольно часто встречается, что страницы-«плагиатчики» Google ранжирует выше первоисточника: две абсолютно одинаковые страницы не могут быть в ТОПе, поэтому не странно, что одна из них «вылетит» во второстепенный индекс. Проверить уникальность текстов можно с помощью специальных , либо вручную посмотреть, как страница ранжируется по куску текста. Главный критерий при этом - ваша страница должна быть в выдаче на первом месте. Если обнаружилось, что контент разворовали, вместо того, чтобы переписывать, более рационально отправить на удаление таких материалов с индекса Google.

Как известно, Google разработал специальный фильтр, который нацелен на борьбу с некачественным контентом - Google Panda. Вот что подразумевается под понятием «некачественный контент»:

- большое количество неуникальных текстов (в разрезе интернета);

- внутренние дубли страниц;

- thin контент;

- в текстах и мета-тегах;

- машинно-генерируемый контент;

- агрессивная перелинковка (с использованием одних и тех же КС);

- скрытый текст;

- клоакинг;

- и другое.

Детально о том, как определить, что сайт под Google Panda, можно прочитать , я же остановлюсь только на основных моментах:

- трафик и позиции просели резко «нырнули»;

- сайт не ищется по кускам текста и title;

- в Google Webmaster Tools много страниц выкинуло с индекса (Индекс Google → Статус индексирования);

- пессимизировало весь сайт, а не отдельные страницы;

- в Google Webmaster Tools намного уменьшилась частота индексирования (Сканирования → Статистика сканирования).

2.3. Проседание трафика, связанный с неестественной ссылочной массой сайта

Вот мы и добрались до самого сложного и самого интересного - как определить качество ссылочной массы? Какие именно ссылки могли послужить причиной пессимизации и проседания трафика?

Заспамленность ссылочного профиля сайта

- настроены ли на сайт 301 редиректы?

- есть ли сквозные ссылки?

- есть ли арендные ссылки?

- есть ли ссылки с линкомоек, не модерируемых каталогов (не для людей)?

- есть ли партнерские ссылки (reciprocal links)?

- есть ли неестественные ссылки в комментариях на блогах (спамные, проставленные программно, не релевантные посту)?

- есть ли ссылки с подписей в форумах?

- есть ли ссылки, которые размещены на площадках, созданных лишь для продажи ссылок?

- присутствует ли в анкор-листе большое количество однотипных коммерческих запросов (например, «купить ламинат киев»)?

- есть ли ссылки, которые не являются естественными, и которые покупали не вы (нужно рассмотреть возможность Negative SEO)?

- были ли ссылочные взрывы?

Если на один или несколько вопросов выше вы ответили «да», то вероятность того, что трафик просел из-за песимизациии за ссылочный фактор, исключать нельзя. После пересмотра ссылочной массы спамные ссылки отправьте в Disavow Links Tool .

Наложены ручные санкции

Google Webmaster Tools является отличным инструментом поисковой оптимизации и, нужно отдать должное Google, еще и площадкой коммуникаций поисковой системы с вебмастером.

Самое, пожалуй, неприятное сообщение, которое можно получить от Google - Меры, принятые в ручную (вкладка «Поисковый трафик → Меры, принятые в ручную»). Наличие сообщения о том, что «меры, принятые в ручную, действуют в отношении определенных страниц, разделов или ссылок» (это в лучшем случае) говорит о том, что причина проседания трафика установлена - осталось понять за что именно санкции наложили. В большинстве случаев - это неестественная ссылочная масса.

Конечно, наличие ручных санкций не гарантирует, что это единственная причина падения позиций и анализ нужно провести полностью, но все же я бы поставил самой приоритетной задачей.

2.4. Другие факторы которые могли повлиять на трафик

Изменения алгоритмов Google

Google регулярно вносит изменения в свои алгоритмы ранжирования и я не говорю только о глобальных доработках, таких, как Колибри или апдейт Панды. Множество небольших, ежедневных изменений, нацелены на улучшение качества выдачи, что, безусловно, влияет на позиции сайта, объем трафика. Следить за «погодой» в мире SEO через сервисы MozCast и Algoroo или за уровнем «шума» на Google Webmaster Forum .

Активизация конкурентов

Активная работа конкурентов по продвижению своих ресурсов может повлиять на трафик подконтрольного вам сайта. Данный фактор не стоит сбрасывать со счетов и учитывать прежде чем принимать важные решения, которые могут и навредить (например, отправить ссылки в Disavow Links). Иногда причина проседания трафика более, чем банальная - поисковик просто видит лучшие альтернативы вашему ресурсу. В таком случае нужно работать над наполнением сайта качественным контентом, наращиванием ссылочной массы, улучшать поведенческие факторы.

Выводы

Существует множество факторов, которые могут служить причиной проседания трафика. И если уж это случилось, то, в первую очередь, нужно сохранять холодную голову и провести тщательный анализ всех возможных причин. Ни в коем случае не делайте поспешных выводов. Даже если вам кажется, что вы нашли в чем дело, все равно проведите полный анализ - возможно, проблема не одна. Только четкое понимание того, что происходит, что стало причиной падения посещаемости, позволит Вам в срок сформировать эффективный план действий и исправить ситуацию.

А что вы делаете в случае когда проседает трафик? Какие методы анализа еще используете?

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Спокойно. Да, он упал. Да, вы потеряли пласт посетителей. Но давайте перестанем паниковать, а первым делом установим причину снижения трафика и устраним её, а уже потом будем предпринимать попытки по возвращению посетителей на ваш сайт.

Для начала давайте разберемся в причинах падения трафика. Посещаемость сайта упала резко и неожиданно или постепенно ? Из какой поисковой системы ? Уже отследили динамику падения ?

Как только вы проанализируете Метрику и установите характер падения, можно уже переходить к детальному изучению причин почему падает посещаемость сайта .

Рассмотрим основные моменты снижения трафика

Давайте проверим из какого поисковика снизился трафик на сайт.

В Метрике переходим в «Стандартные отчеты→ Источники → Источники, Сводка», выбираем период упадка посещаемости сайта , а затем проводим анализ полученных данных.

Как видим, в данном случае спад трафика произошел в Яндексе .

Что у нас тут? Трафик лежит с марта. Чтобы определить, насколько именно упала посещаемость сайта (начиная с марта, если сравнивать с предыдущими месяцами) выберем период просадки (март-май). Чтобы построить график только по переходам из поисковиков ниже в таблице снимите галочку напротив других источников. Затем применяем сравнение сегментов «Сравнить с предыдущим периодом». В итоге получаем вот такую занимательную диаграмму:

Как видим трафик из Яндекса упал больше чем в 2 раза.

Выясняем причины падения поискового трафика

1. Проверяем работу сервиса сбора статистики

Иногда бывают сбои в работе этого сервиса и данные начинают поступать ложные. Находим место расположения кода учета статистики и сравниваем его с оригинальным вариантом. Если все хорошо, то двигаемся дальше.

2. Изменения на сайте

Если на сайте производились какие-либо перемены в дизайне или производилось удаление значительной части контента или страниц, то это может повлечь за собой такие неприятности, как снижение посещения ресурса. В этой ситуации лучше всего сделать откат, вернув свой сайт в прежнее положение.

3. Сезонность

Если тематика вашего бизнеса имеет сезонный спрос на товары / услуги, то и трафик на сайте в «несезонные» месяцы будет падать. Такова уж специфика данного явления. Посмотреть трафика можно в Яндекс.Вордстат.

Вводим запрос→ История запросов, выбираем группировку по месяцам или по неделям.

На скрине ясно видно, что по запросу «новогодние игрушки» трафик посетителей в основном будет с ноября по январь и основной его пик приходится, естественно, на декабрь.

4. Причина падения трафика - технические ошибки на вашем сайте

- Проверяем файл robots.txt. Если этот файл настроен плохо / ошибочно / неверно, то это вполне может спровоцировать выпадение страниц из поиска. Иногда в robots случайно закрывают ключевые страницы или разделы. Поэтому подробно и внимательно изучите этот файл.

- Неправильная настройка редиректа с зеркал сайта. Криво настроенные редиректы могут привести к смене релевантной страницы и соответственно к понижению в поисковой выдаче вашего ресурса.

- Проблемы с хостингом. Если ваш хостинг будет работать нестабильно, то и ваш сайт будет недоступен как поисковикам, так и посетителям.

- Наличие неуникального / дублированного контента. Много дублей страниц сильно запутывает поисковых роботов, им сложно определить какая же страница является наиболее релевантной для определенного запроса. А также может повлечь наложение санкций ПС. Найти на сайте дублированный контент можно при помощи Google Webmaster. В панели инструментов заходим в «Вид в поиске» → «Оптимизация HTML».

Здесь мы видим количество повторяющихся заголовков страниц, которые, скорее всего, одинаковы и по содержанию. От дублированного контента обязательно нужно избавляться.

- Внешние ссылки. Иногда злоумышленники взламывают сайт и с помощью вирусной программы устанавливают на него код ссылочной биржи. Обязательно проверьте этот момент. Для этого можно использовать такие ресурсы как Linkpad.ru или Mainspy.ru .

- Проверяем скорость загрузки сайта. «Торможение» сайта приводить к снижению его видимости в поиске и постепенно ухудшается посещаемость. Стоит отметить, что Яндекс более чувствителен к скорости загрузки сайта чем Google. К тому же при медленной загрузке могут значительно ухудшится поведенческие факторы.

5. Смена алгоритмов Яндекc и Google

Узнайте не обновляли ли свои алгоритмы ранжирования поисковиков. Пошарьте на форуме Searchengines.guru или загляните в Блог Яндекса - там сообщают официальные сведения о новых алгоритмах ранжирования.

Если просел трафик с Google, то прежде всего проверяем не наложены ли ручные санкции. А также не совпадает ли эта просадка с датами обновления Пингвина, Панды или другими фильтрами Google.

Если вы удостоверились в том, что алгоритм изменился, то вполне логично предположить, что падение посещаемости сайта связанно именно с этим. Изучайте принципы работы нового алгоритма и делайте соответствующие выводы.

6. Проверяем сайт на возможное наложение санкций

Есть замечательный бесплатный инструмент диагностики от Seolib.ru . Он поможет сопоставить ваш трафик с нововведениями и всевозможными дополнениями фильтров поисковых систем. Данные представлены очень удобно, в виде графика.

Чтобы узнать наверняка, советую написать в техподдержку Яндекса, дабы убедиться в том, что ваш сайт чист от санкций.

7. Происки конкурентов - как причина спада трафика на сайт

Иногда трафик проседает из-за недобросовестных действий ваших конкурентов, которые покупают спамные ссылки на ваш сайт с низкокачественных ресурсов, так называемых «ГСов». Или прогоняют ваш сайт по «черным» базам каталогов Хрумером или другими хитрыми инструментами. Стоит это довольно недорого, поэтому нечистые на руку конкуренты не гнушаться этим методом.

Более развернутую картину по ссылкам вам помогут составить такие сервисы как Megaindex или Linkpad .

В Google в Search Console для этого есть специальный инструмент - Disavow tool. Благодаря ему можно указать домены с которых стоят «плохие» ссылки и они не будут ранжироваться. Попробуйте связаться с владельцами или админами площадок, с которых стоят некачественные ссылки на ваш сайт и попросите их убрать. Также можно прописать атрибут к ссылкам (дабы не передавать вес своей страницы).

8. Контент низкого качества

Ни для кого не секрет, что контент в интернете очень часто воруют. Если вы заметили, что контент вашего сайта потерял свою уникальность, то это может стать причиной проседания трафика. Также стоит проверить, не слетели ли метатеги со страниц сайта, например, при обновлении CMS.

Падение трафика на вашем сайте: итог

Если вы заметили резкое снижение трафика на сайт, то первым делом проанализируйте показатели и попробуйте установить причину.

Напрягаем память и пытаемся найти в чертогах разума, какие манипуляции производились с проектом в период 1−3 месяца до этого события. Когда причина будет найдена, устраняем её. И помним, что любая проблема имеет свое решение.

Выяснили причину и радуемся, но не сильно

Вы достигли результата! Поздравляем! Можно расслабиться и пожинать плоды? Не так быстро!

Давайте рассмотрим изменения, которые влияют на позиции сайтов в поисковых системах, а также могут вовсе лишить ваш сайт трафика, а соответственно и уменьшить количество ваших клиентов и ваш доход:

- Не стоит останавливаться на достигнутом.

Ваш сайт должен постоянно развиваться. Ваши конкуренты не стоят на месте. Вы не должны отставать от них. - Не стоит недооценивать поисковые машины.

Вот вы в топе, значит поисковая машина посчитала, что ваш сайт может быть интересен пользователям, то есть удовлетворяет ряду факторов ранжирования. Стоит помнить, что алгоритмы поисковых машин постоянно меняются и совершенствуются. Регулярно привносятся дополнительные требования к сайту, необходимо соответствовать этим факторам, чтобы оставаться на «высоте». - Не делайте резких движений. Ваш сайт - это «живой организм». Не стоит наносить ему вред, придется восстанавливать его. Нужно обдумывать каждое изменение на сайте. Не стоит пренебрегать техническими возможностями сервера, на котором хранится ваш сайт, изменять URL-ы или мета-теги страниц сайта. Необходимо постоянно поддерживать свой ресурс.

Как повысить трафик сайта? Ищите ответы в нашем блоге.

Портал о персональных компьютерах

Портал о персональных компьютерах